«Искусственный интеллект не защитит, если не использовать интеллект естественный»: как развитие ИИ влияет на кибербезопасность

Теперь спамеры могут присылать 3 млрд писем ежемесячно вместо 100 тыс. Но положительное влияние тоже есть.

Системы искусственного интеллекта (ИИ) помогают усилить кибербезопасность: распознают аномалии и новые типы злонамеренного софта, извещают об угрозах и защищают критические данные. А появление технологий типа ChatGPT и Bard расширило их возможности еще больше.

Впрочем, в эту игру можно играть вдвоем. Киберпреступники также используют ИИ, чтобы совершать более сложные и целенаправленные атаки. Например, генерируют фишинговые письма с помощью языковых моделей или даже имитируют чужой голос и видеоизображение.

О том, как развитие ИИ меняет индустрию кибербезопасности, какие преимущества и риски связаны с распространением таких технологий и следует ли уже сейчас волноваться об угрозах будущих кибервойн, рассказывает Михаил Кольцов — внешний консультант The World Bank Group в области анализа данных и кибербезопасности.

Далее со слов Михаила.

Михаил Кольцов, внешний консультант The World Bank Group в области анализа данных и кибербезопасности

Ограничение классических систем ИИ

Системы искусственного интеллекта, построенные на основе алгоритмов машинного обучения и лингвистических нейросетей, давно стали частью современных инструментов для защиты данных.

Есть несколько сфер, в которых они используются. Прежде всего это обнаружение проникновения — когда нужно понять, что в ваш периметр кто-нибудь залез. Система может автоматически распознать сигнатуру злонамеренного кода или входящего интернет-трафика, среагировать на аномальное поведение пользователей. К примеру, алгоритм замечает, что человек в 12 ночи обращается к файлу с персональными данными клиентов, — вероятно, это действия хакера.

Алгоритмы машинного обучения хорошо справляются с фильтрованием спама — речь идет о почтовых фильтрах, позволяющих уменьшить фишинговую нагрузку на персонал компании. Ведь можно неоднократно предупреждать сотрудников, чтобы они не открывали подозрительные письма, но человеческий фактор непредсказуем. Лучше настроить спам-фильтр, чтобы человек вообще не видел сообщений от мошенников.

Классические системы ИИ работают с распознаванием уже известных угроз. Но новые способы взлома появляются чуть ли не каждый день. Поэтому важно уметь предусматривать злонамеренные действия и реагировать на уязвимости еще до того, как они станут активными. Справиться с такой задачей способны инструменты на основе генеративных моделей ИИ, которые могут не только измерять определенные паттерны, но и формировать контент. Это перспективный тренд по созданию как антивирусов, так и коммерческих продуктов для кибербезопасности.

Больше о трендах 2023 года в кибербезопасности можно будет послушать на лекции Михаила Кольцова уже 17 августа на онлайн-конференции от robot_dreams — STRUM. Участие в мероприятии бесплатное.

Возможности генеративных моделей

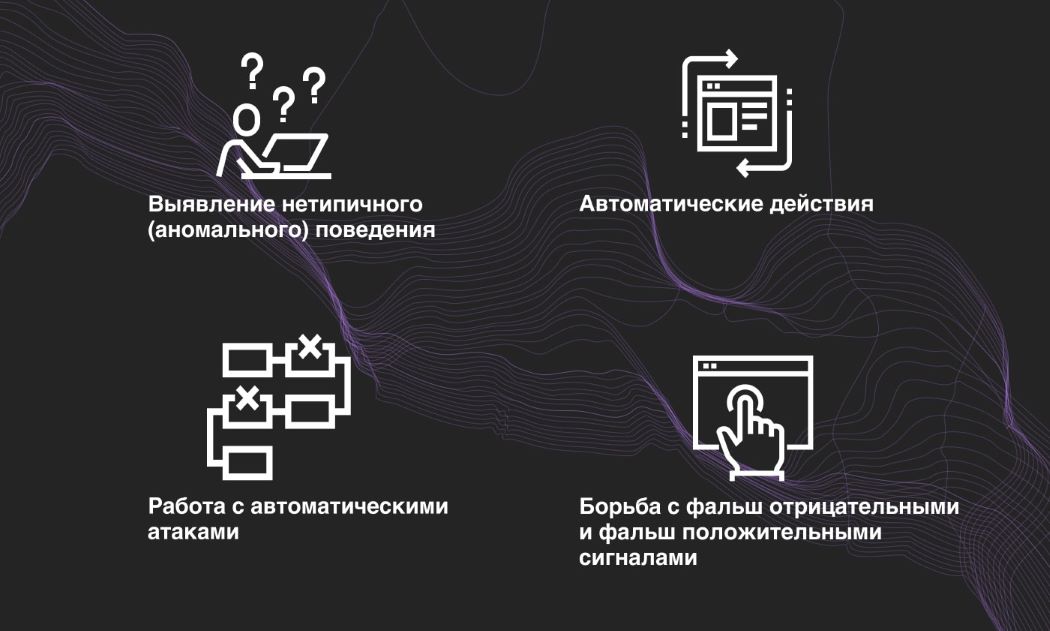

Рассмотрим ключевые преимущества и возможности систем генеративного ИИ в плоскости киберзащиты:

- Выявление нетипичного (аномального) поведения. Для классических систем защиты мы задаем определенные критерии, по которым поведение пользователей будет считаться злонамеренным. Совпадает несколько таких факторов — фиксируется вторжение. В то же время генеративный ИИ может заметить критерии, о которых мы сами еще не догадываемся, с которыми никогда раньше не сталкивались. Таким образом можно скомбинировать лучшую предикативную модель.

- Автоматические действия. Мало выявить угрозу — крайне важно вовремя отреагировать на нее и имплементировать систему защиты. Модели, сгенерированные алгоритмами генеративного ИИ, способны делать это как можно быстрее.

- Работа с автоматическими атаками. В большинстве своем на крупные компании нападают не люди, а алгоритмы. Обычно человек не способен адекватно ответить на этот вызов, ведь злонамеренные программы постоянно видоизменяются. Впрочем, одному боту можно и нужно противопоставить другого бота.

- Борьба с фальшотрицательными и фальшположительными сигналами. В корпоративной кибербезопасности система должна одновременно отслеживать многие события: интернет-трафик, обращение на сайт и т. д. Среди этого «шума» легко усилиться и трактовать обычное поведение как злонамеренное — или наоборот. Пока это основная проблема кибербезопасности, и генеративный ИИ имеет большие шансы уменьшить количество неправильно проинтерпретированных сигналов.

Биометрическая аутентификация — утихающий тренд

Поскольку системы генеративного ИИ появились недавно, они уже заметно влияют на отрасль кибербезопасности. Например, биометрическая аутентификация, которая имплементирована почти в каждый телефон, все еще считается хорошей защитой конечных пользователей, но становится все менее надежным средством в корпоративном мире.

Наши отпечатки пальцев или лица уникальны только с позиции человека. Но для машины это просто определенное сочетание точек. Например, если хакер получит доступ к камере, он может сгенерировать достаточное количество изображений и создавать цифровой отпечаток вашего лица.

Поэтому в корпорациях отказываются от биометрической аутентификации в пользу FIDO-токенов — специальных устройств, служащих вторым фактором при проверке личного идентификатора. Биометрия же остается вспомогательным средством в крупных корпорациях — например, для распознавания сотрудников, которые заходят в помещение.

Как выглядит FIDO-токен

Генеративный ИИ в руках хакеров: какие есть риски

Основная угроза распространения открытых инструментов генеративного ИИ — в том, что эти технологии будут доступны не только для киберзащиты, но и для кибернападения. Хотя текущая инфраструктура на уровне ChatGPT не позволяет хакерам создавать новые вирусы или модифицировать текущие, они могут использовать ее в режиме co-pilot. А значит — тратить гораздо меньше времени на подготовку атак.

К примеру, недавно появился автоматизированный алгоритм WormGPT. Он помогает мошенникам генерировать убедительные спам-письма, которые обходят систему спам-фильтров. Для этого система использует датасет бизнес-писем из взломанных корпоративных почтовых ящиков.

Как следствие, за последний год увеличилось количество инцидентов с фишингом, вирусами-вымогателями и т. д. При этом киберпреступников не стало больше — просто теперь один человек может расширить охват своей деятельности. К примеру, посылать не 100 тыс. спамерских писем ежемесячно, а 3 млрд.

Генеративный интеллект позволяет подделывать и голос другого человека. Уже было несколько случаев, когда мошенник имитировал голос одного из руководителей компании и по телефону приказывал перевести на свой счет несколько миллионов долларов. Более распространенные схемы: скамер звонит родственникам жертвы и рассказывает историю типа «ваш внук в полиции — заплатите деньги, чтобы его отпустили». В США ежегодные потери от таких атак составляют 20–27 млн долларов.

Пока сгенерированные голоса неидеальны. Они роботизированы и не передают нюансы. Такой вид атаки больше эксплуатирует человеческую уязвимость и невнимательность. Также хакеры еще не научились делать достоверные видеоотпечатки лица.

Проблемы сгенерированного кода

Еще один риск, возникший с появлением инструментов типа ChatGPT, — снижение качества кода. Представим, что разработчик сгенерировал код для собственной задачи, а тот содержит определенные уязвимости. Если у программиста нет достаточной квалификации, чтобы это понять, — не избежать проблем.

Кроме собственно уязвимостей, таким образом можно нарушить коммерческую тайну. Ведь когда разработчик дает ChatGPT фрагмент своего кода и просит его модифицировать, система пополняет свой датасет. Другими словами, этот код попадает в открытый доступ. И потом, когда другой человек попытается сгенерировать код, решающий схожую задачу, ChatGPT может предложить ему фрагмент того же чужого кода. Фактически интеллектуальная собственность перейдет к другому человеку или компании.

Поэтому многие IT-компании уже запретили своим разработчикам пользоваться генеративным ИИ во время программирования.

Ключевой вопрос — стоимость

Компании, для которых важна бесперебойность сервисов и работа с чувствительными данными, все больше и больше интересуются средствами кибербезопасности с использованием ИИ. Этот тренд заметен и в Украине — в первую очередь среди инновационных банков и бизнесов, работающих с технологической инфраструктурой и большими массивами данных.

Ключевой вопрос, определяющий скорость разработки инновационных средств защиты данных, — в стоимости этих технологий. Обычно речь идет о 6-значных и даже 7-значных цифрах. Даже в бигтех типа Meta пока не уверены, стоит ли отдавать такие суммы за серверы и создание датасетов, лишь бы использовать все возможности генеративных моделей.

Набирает обороты киберзащита как услуга, которая включает в себя как средства классической защиты, так и применение алгоритмов генеративного обучения. В Украине одним из лидеров этой ниши считается «Київстар».

Наибольшим барьером для использования ИИ в кибербезопасности является RoSI (Return on Security Investment), когда компании нужно обосновать закупку дополнительных инструментов с точки зрения затрат. Обычно логика при построении корпоративной киберзащиты такова: ее стоимость не должна превышать потенциальные потери от кибератаки.

К примеру, в компании имплементирована защита на основе уникальных сигнатур распространенных вирусов. Это защищает бизнес от 30–60 % атак. Если такой риск приемлем, можно не тратить деньги на средства генеративного ИИ, которые будут отражать 80–92 % атак.

Кстати, высокая стоимость ресурсов для развития генеративного ИИ — гарантия того, что единичные хакеры не смогут использовать его для подготовки атак серьезнее фишинга. Фактически сейчас хакерская группа может получить доступ к нужной инфраструктуре только при государственной поддержке — например, для разработки кибероружия в интересах этого государства.

ИИ – не волшебная таблетка

Однажды я расследовал киберинцидент в компании: хакеры взломали компьютер сотрудника и ворвались в корпоративную систему. Выяснилось, что этот сотрудник хранил пароли от AWS прямо в текстовом файле на рабочем столе. Таких случаев немало.

Кибербезопасность — это всегда кооперация между человеком и машиной. Поэтому, сколько бы денег бизнес не тратил на современные инструменты киберзащиты с использованием ИИ, они не будут работать, если не применять обычный интеллект.

Также следует помнить, что система с искусственным интеллектом не может решать все проблемы кибербезопасности. Это не волшебная таблетка. Первоначально компания должна построить несколько уровней защиты традиционными средствами — как основу. Только после этого можно добавить инструменты на базе ИИ — как надстройку.

Если сразу взять инструменты, построенные на ИИ, есть риск попасть в ловушку ошибочного ощущения защиты. Например, алгоритмы машинного обучения очень чувствительны к датасету, на котором они учатся. Если злоумышленник сможет манипулировать этим датасетом и научит алгоритм «не замечать» определенные аномалии, тот станет уязвим к таким атакам. Пока еще нет способов этому противостоять.

Однако тенденция идет к тому, что в перспективе 5–10 лет средства кибербезопасности на основе ИИ будут использоваться все шире. Пользователи цифровых продуктов и услуг ожидают, что их данные будут защищены, и бизнес должен это учитывать. Развитие инструментов киберзащиты и кибернападения — это непрерывный процесс. Чем лучше хакерам удается взламывать системы, тем надежнее должна становиться их защита.

Напоминаем, что больше о кибербезопасности Михаил Кольцов расскажет 17 августа на бесплатной онлайн-конференции от robot_dreams — STRUM. Регистрация на мероприятие уже открыта.